CVPR2021佳作 | 重新標記ImageNet:從全局標簽到局部標簽

ImageNet可以說是最受歡迎的圖像分類基準,但它也是一個具有顯著噪聲的標簽。最近的研究表明,許多樣本包含多個類,盡管被假定為單個標簽基準。因此,他們建議將ImageNet評估變成一個多標簽任務,每個圖像都有詳盡的多標簽注釋。然而,他們還沒有固定訓練集,大概是因為強大的注釋成本。

1.動機

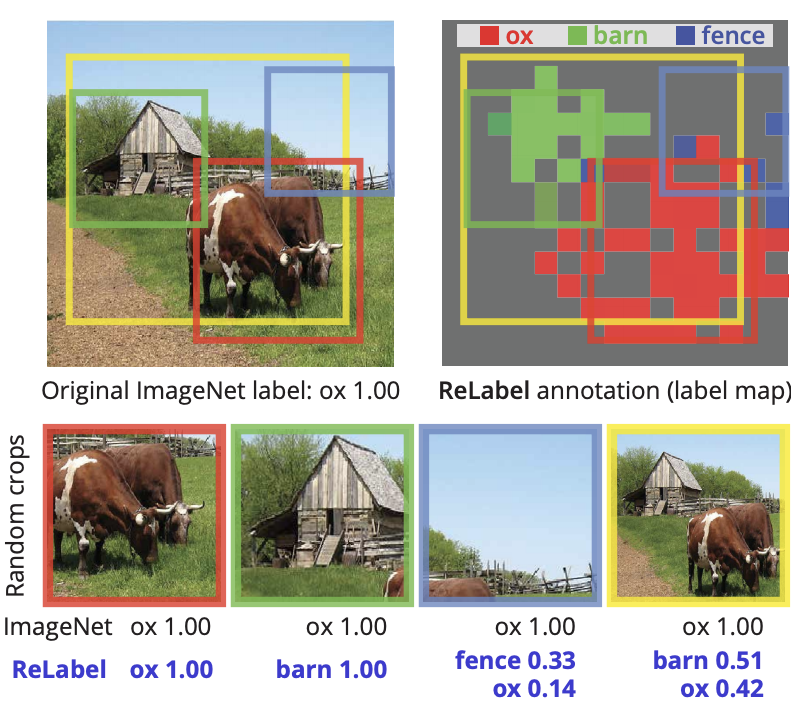

所以作者認為在訓練設置中,單標簽注釋和有效的多標簽圖像之間的不匹配是同樣的問題。使用單標簽注釋,圖像的隨機裁剪可能包含與真值完全不同的目標,在訓練過程中引入噪聲甚至不正確的監督。因此,作者用多標簽重新標記ImageNet訓練集。

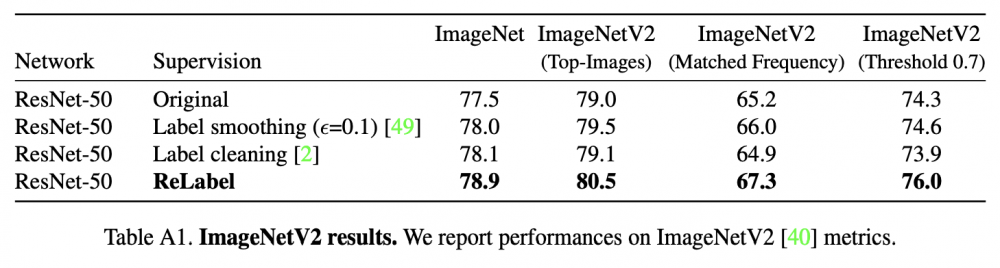

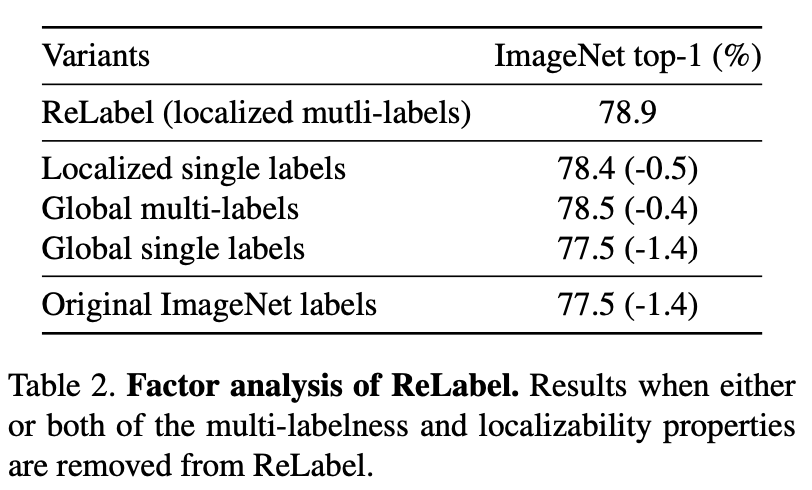

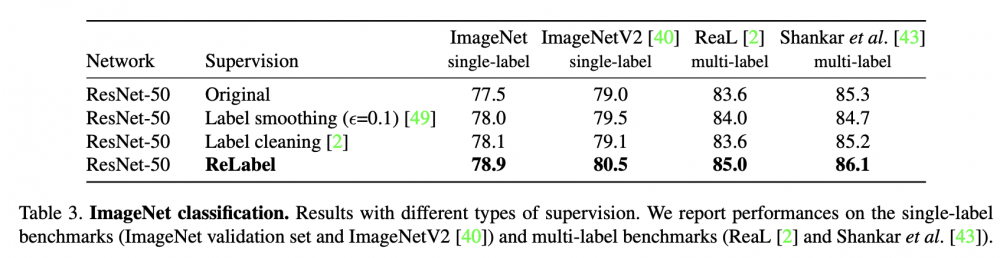

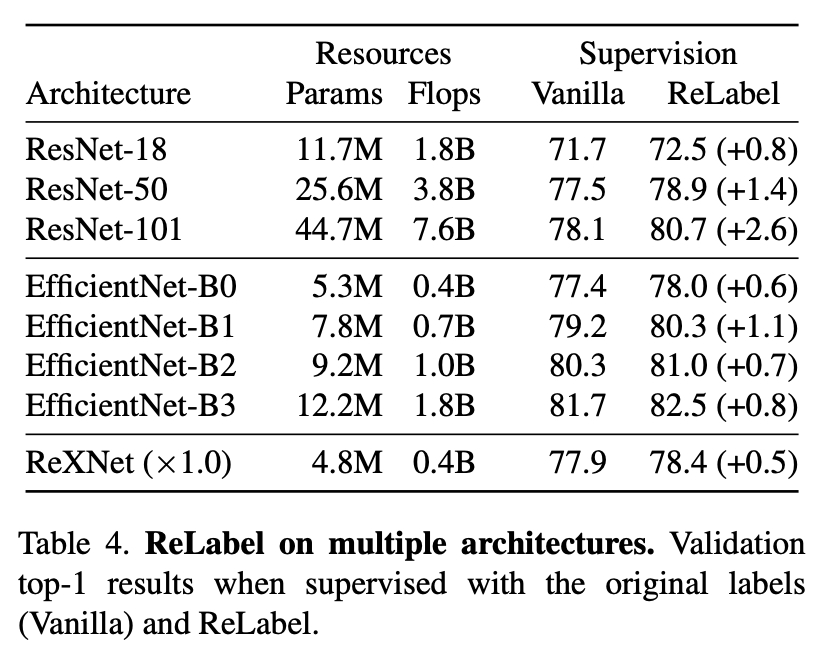

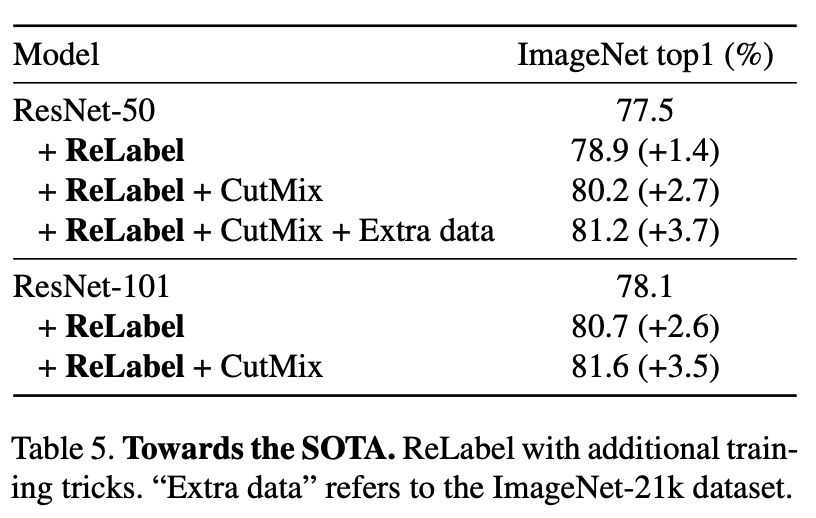

通過讓一個強大的圖像分類器,在額外的數據源上訓練,生成多標簽來解決注釋成本障礙。利用最終池化層之前的像素級多標簽預測,以利用額外的特定位置的監督信號。對重新標記的樣本進行訓練,可以全面提高模型性能。在ImageNet上,ResNet-50的分類精度達到了78.9%,局部多標簽,這可以進一步提高到80.2%。作者表明,用局部多標簽訓練的模型也優于遷移學習到目標檢測和實例分割任務的基線,以及各種魯棒性基準。

2.引言

每個圖像的目標類的多樣性與單個標簽的分配之間的不匹配不僅導致了評估問題,而且還導致了訓練問題:監督變的嘈雜。random crop augmentation的廣泛采用加劇了這一問題。圖像的隨機裁剪可能包含與原始單個標簽完全不同的對象,在訓練過程中引入潛在的錯誤監督信號,如下圖所示。

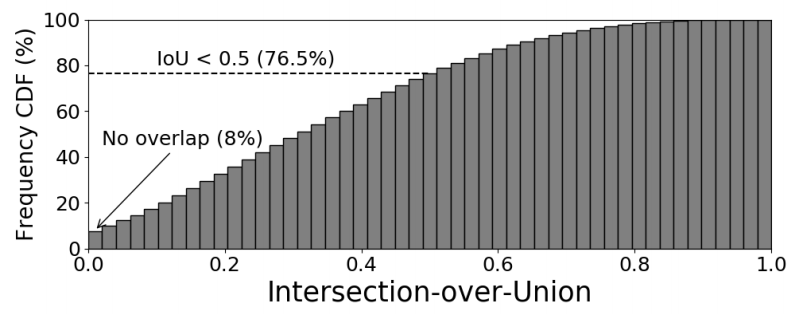

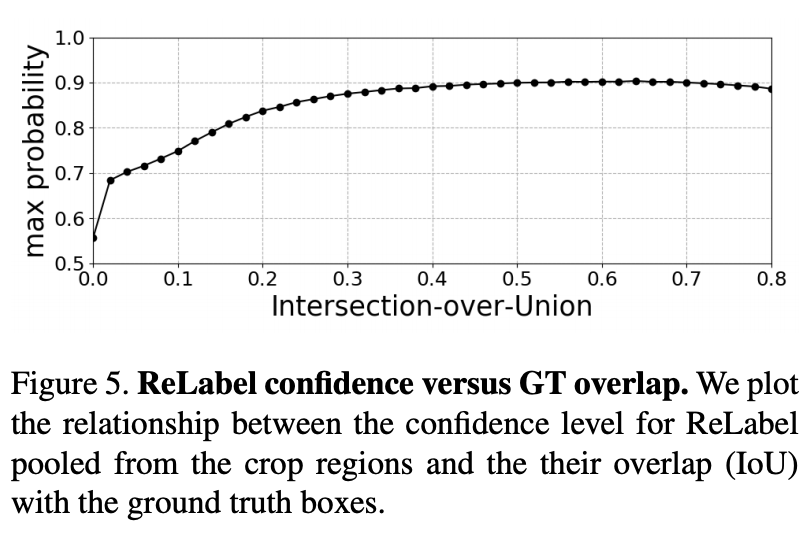

Random crop augmentation不僅對具有多個對象類的圖像產生監督噪聲。即使對于具有單個對象類的圖像,隨機裁剪通常也不包含前景對象。據估計,在標準的ImageNet訓練設置下,8%的隨機裁剪與真實值沒有重疊。只有23.5%的隨機裁剪與真實的IoU大于50%(見下圖)。在ImageNet上訓練模型不可避免地涉及到許多嘈雜的監督信號。

3.問題

Labeling issues in ImageNet

ImageNet有效地作為圖像分類器的標準基準,Shankar等人認為:“方法在這個基準上的性能是活的還是死的”。

因此,基準本身的可靠性已成為認真研究和分析的主題。與許多其他數據集一樣,ImageNet包含許多標簽噪聲。在ImageNet上最持久和系統的標簽錯誤類型之一是錯誤的單個標簽,指的是在多個現有類別中只有一個被注釋的情況。這種錯誤很普遍,因為ImageNet包含許多具有多個類的圖像。

Shankar等人和Beyer等人為錯誤的單個標簽確定了三個子類別:

(1) 圖像包含多個對象類,

(2 )存在多個同義或層次性的標簽,包括另一個,

(3) 圖像中固有的模糊性使多個標簽可信。

這些研究已經將驗證集標簽細化為多標簽,以對有效的多標簽圖像建立真實和公平的模型評估。然而,[Vaishaal Shankar, Rebecca Roelofs, Horia Mania, Alex Fang, Benjamin Recht, and Ludwig Schmidt. Evaluating machine accuracy on imagenet. In Proceedings of the 37th International Conference on Machine Learning, 2020]關注的重點只是驗證,而不是訓練。[Lucas Beyer, Olivier J Henaff, Alexander Kolesnikov, Xiaohua Zhai, and Aaron van den Oord. Are we done with imagenet? arXiv preprint arXiv:2006.07159, 2020]引入了一種清理方案,通過使用強分類器的預測來驗證來刪除具有潛在錯誤標簽的訓練樣本。

作者的工作重點是對ImageNet訓練標簽的清理策略。和[Lucas Beyer, Olivier J Henaff, Alexander Kolesnikov, Xiaohua Zhai, and Aaron van den Oord. Are we done with imagenet? arXiv preprint arXiv:2006.07159, 2020]一樣,作者也使用強分類器來清理訓練標簽。與其不同的是,作者糾正了錯誤的標簽,而不是刪除。

作者提出的標簽也是在每個地區給出的。在實驗中表明,新的方案比[Lucas Beyer, Olivier J Henaff, Alexander Kolesnikov, Xiaohua Zhai, and Aaron van den Oord. Are we done with imagenet? arXiv preprint arXiv:2006.07159, 2020]提高了性能。

4.Re-labeling ImageNet

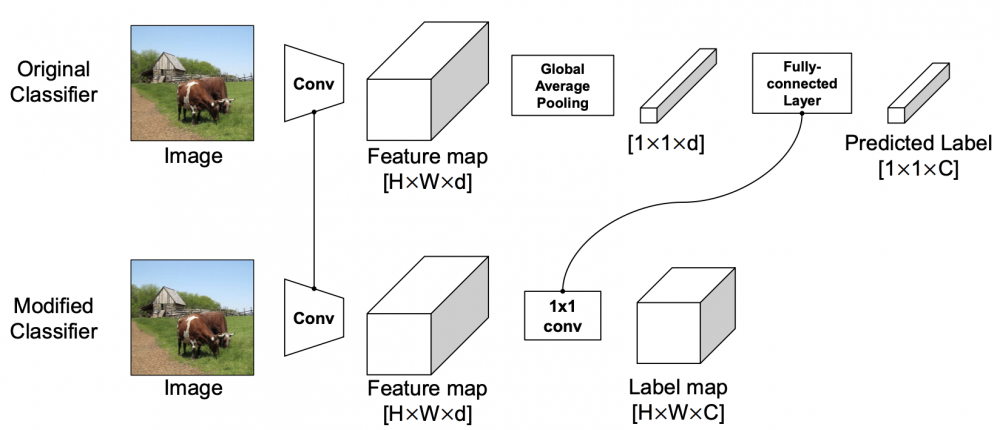

Training a Classifier with Dense Multi-labels

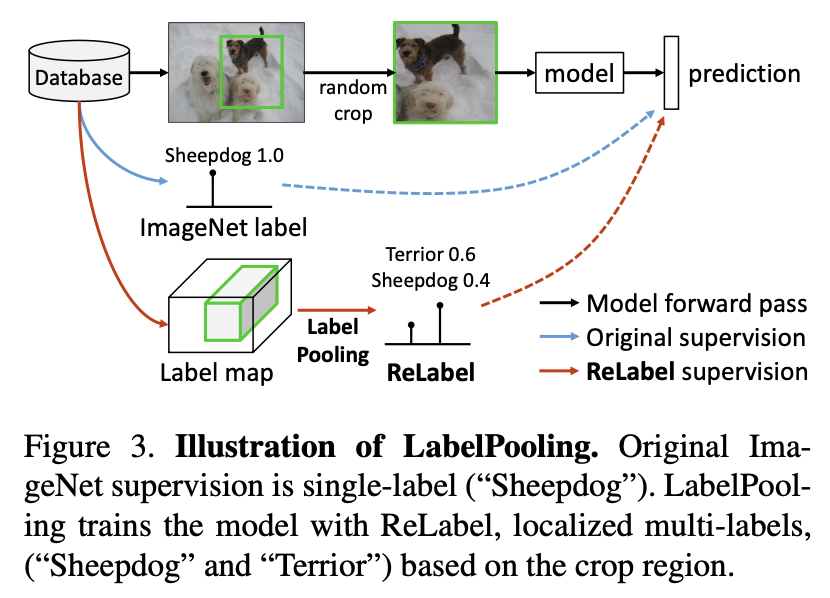

在獲得了如上所述的密集多標簽L∈RW×H×C之后,我們如何用它們訓練分類器?

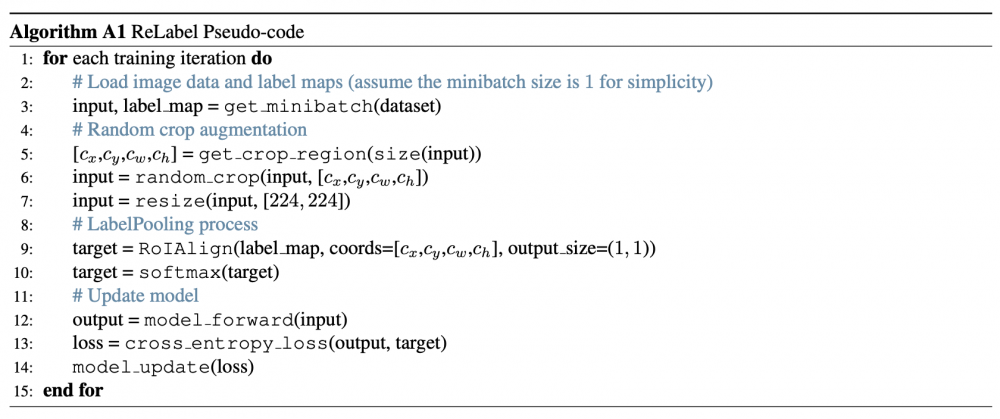

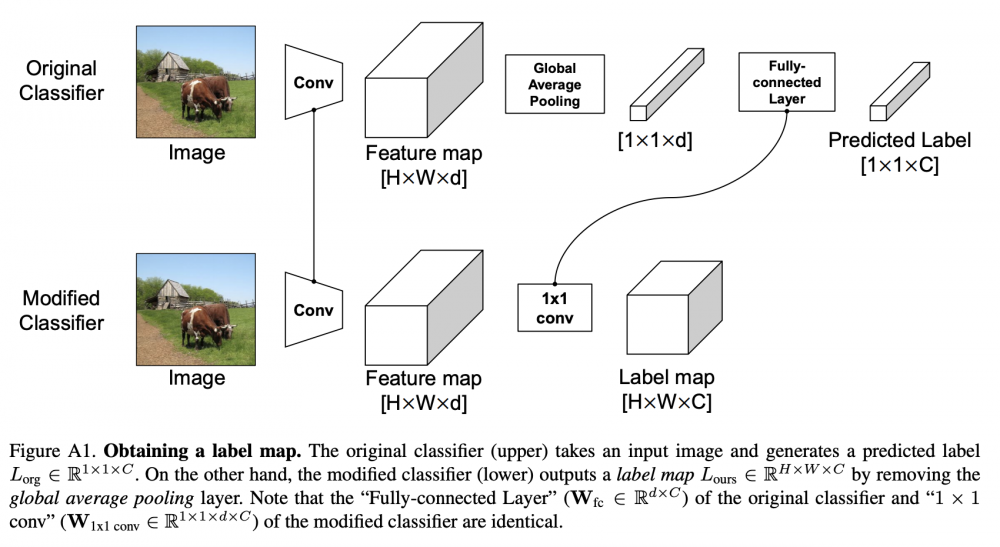

為此,提出了一種新的訓練方案,LabelPooling(標簽池化),它考慮了局部真值。在上圖中顯示了標簽池化和原始ImageNet訓練之間的區別。在一個標準的ImageNet訓練設置中,隨機裁剪的監督是由每個圖像給出的單個標簽真值給出的。另一方面,標簽池加載一個預先計算的標簽映射,并在標簽映射上進行與隨機裁剪坐標對應的區域池化操作。 作者采用RoIAlign區域池化方法,在集合預測映射上執行全局平均池化和Softmax操作,以獲得[0,1]中的多標簽真值向量,并與該模型進行訓練。使用交叉熵損失,訓練計劃的偽代碼實施情況如下:

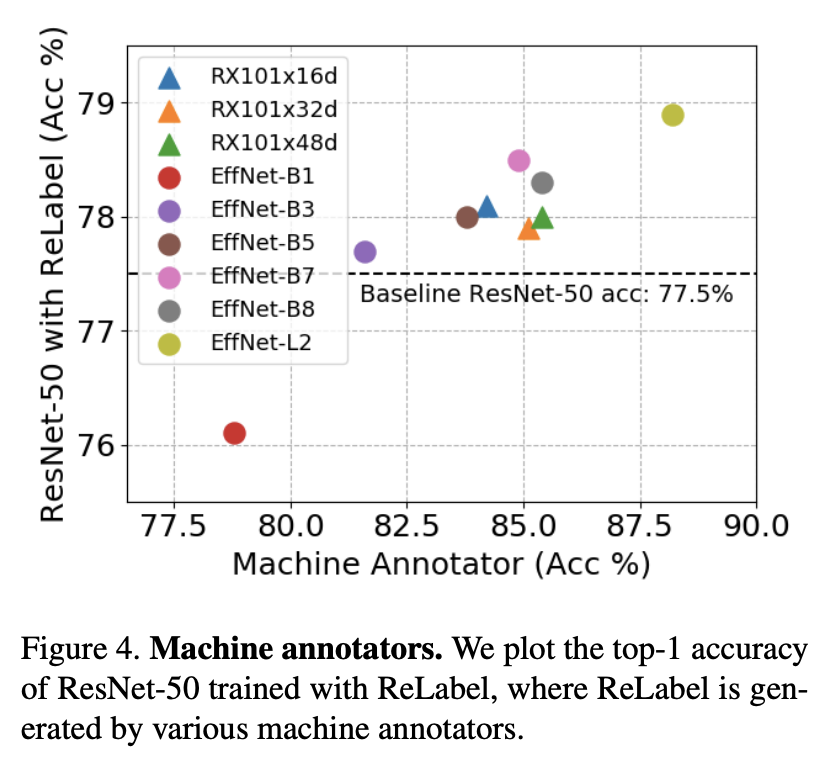

Which machine annotator should we select?

目標模型的性能總體上遵循machine annotator的性能。當機器監督不夠強(例如,EfficientNet-B1)時,經過訓練的模型表現出嚴重的性能下降(76.1%)。我們選擇EfficientNet-L2作為機器注釋器,在其余的實驗中,ResNet-50(78.9%)的性能最好。

5.實驗結果

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。